모두연 서비스 바로가기

모두연 KDT

모두의연구소 아이펠 부트캠프

커뮤니티 기반의 성장형 AI/DATA 교육 플랫폼에서 함께 성장해요!

더 알아보기모두연 온라인 교육상품

모두의연구소 추천 강의

AI 교육만 10년, AI 교육 전문 기업 모두의연구소 클래스

더 알아보기

바이브 코딩 with Cursor: 챗봇, DB 배포까지

90%17,900원

179,000원- #NEW

- #바이브코딩

- #🪙국비지원

비개발자도 할 수 있는 바이브 코딩 업무 자동화

90%25,410원

254,100원- #NEW

- #바이브코딩

- #🪙국비지원

일상부터 업무까지: ChatGPT와 친해지기

90%23,700원

237,000원- #NEW

- #🐥왕초보

- #🪙국비지원

AI로 시작하는 콘텐츠 크리에이터

90%20,000원

200,000원- #NEW

- #🪙국비지원

비개발자도 할 수 있는 바이브 코딩 웹 개발

90%23,700원

237,000원- #NEW

- #🐥왕초보

- #바이브코딩

- #🪙국비지원

![[첫걸음] 데이터를 보는 눈, 파이썬으로 배우는 통계 기초](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fhome-section%2Fmain-online-kdc%2Fda43d344-fec9-407f-bec9-67c61e7bbd70.jpg&w=3840&q=75)

[첫걸음] 데이터를 보는 눈, 파이썬으로 배우는 통계 기초

90%16,900원

169,000원- #NEW

- #🐥왕초보

- #🪙국비지원

![[첫걸음] 기본부터 탄탄하게, 파이썬 데이터 분석 첫 만남](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fhome-section%2Fmain-online-kdc%2Fd1a26177-0d9a-4d92-af84-062736818557.jpg&w=3840&q=75)

[첫걸음] 기본부터 탄탄하게, 파이썬 데이터 분석 첫 만남

90%13,700원

137,000원- #NEW

- #🐥왕초보

- #🪙국비지원

생성형 AI를 활용한 15초 광고(숏폼) 만들기

90%20,000원

200,000원- #BEST

- #🐥왕초보

- #🪙국비지원

함께 성장하는 즐거움, 모두모임

스터디, 북클럽, 챌린지! 크루들과 함께 성장해 보세요

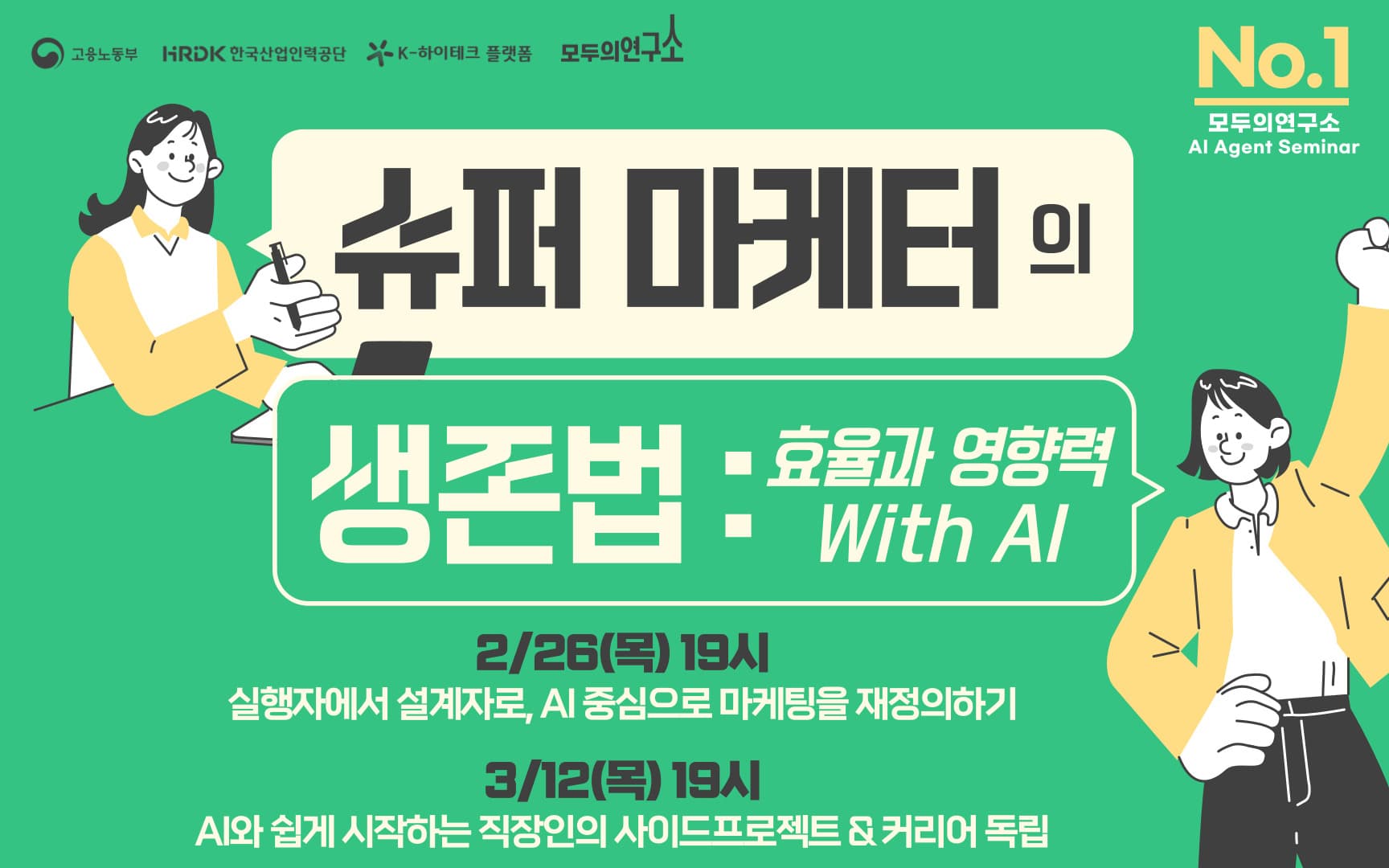

더 알아보기모두연 세미나

모두의연구소 세미나

AI부터 SW까지, 지식과 노하우를 공유하는 세미나가 열립니다.

더 알아보기모두의 연구소 LAB

함께하는 모두의 연구실, LAB

연구하고 싶은 주제가 있다면, 누구나 LAB을 만들고 참여할 수 있어요.

더 알아보기

B-Peach Paper LAB

AI 쉬운말 번안 평가 프레임워크 고도화 및 논문작성

모집중진행중- #llm

- #번안

- #textadaptation

- #문학

- #llm

- #번안

- #textadaptation

- #문학

AI 페르소나 LAB

AI 에이전트 페르소나 명세의 크로스플랫폼 무결성을 연구합니다

모집중진행전- ##llm

- ##ai에이전트

- #페르소나

- #soulspec

- #크로스모달

- ##llm

- ##ai에이전트

- #페르소나

- #soulspec

- #크로스모달

Advanced Computer Vision LAB 3 LAB

최신 Computer vision 및 AI 관련 연구를 위한 LAB입니다.

모집중진행전- ##computervision

- ##multimodal

- ##agent

- ##computervision

- ##multimodal

- ##agent

Microsoft Fabric & Copilot LAB

Microsoft Fabric & Copilot

모집중진행전- ##microsoftfabric

- ##powerbi

- ##copilot

- ##microsoftfabric

- ##powerbi

- ##copilot

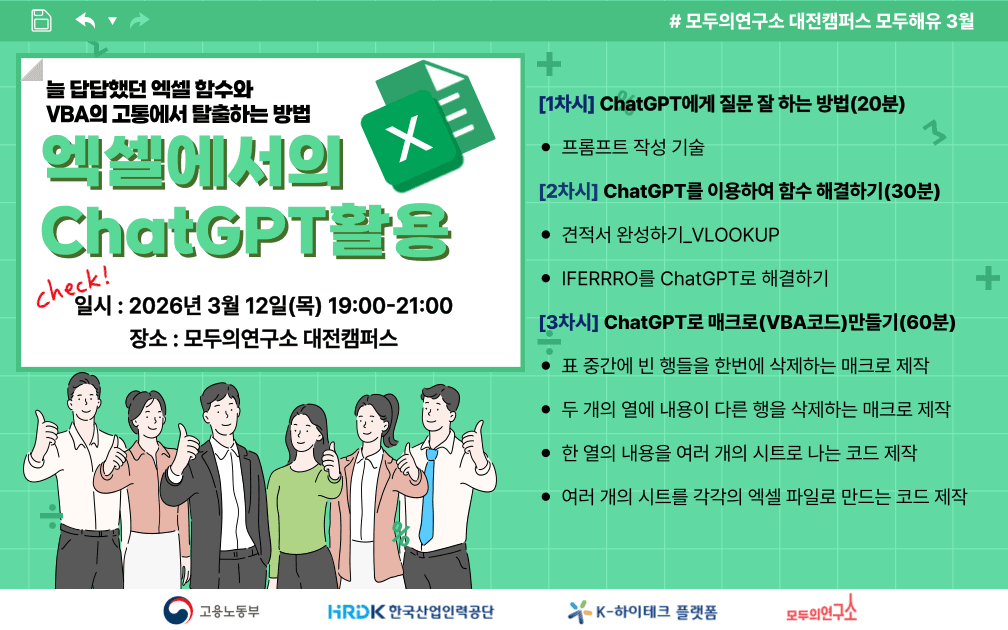

직장인 무료 교육 & 세미나

직장인 무료 교육

AI를 활용해 업무 효율성을 향상시킬 수 있을까요? 있습니다! 2일만 투자하세요!

더 알아보기모두의연구소 블로그

모두의연구소에서 발행하는 최신 AI 콘텐츠를 만나보세요.

더 알아보기

![[모두팝/오프라인] 양자컴퓨팅과 AI의 만남: 양자컴퓨터를 활용한 AI 서비스와 글로벌 사례 with 노르마](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fmomo%2Fthumbnail%2Fb3ad0521-fb66-4368-98e7-8d7f799b2186.png&w=3840&q=100)

![[모두팝/온라인] 양자컴퓨팅과 AI의 만남: 양자컴퓨터를 활용한 AI 서비스와 글로벌 사례 with 노르마](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fmomo%2Fthumbnail%2F5214c166-d744-4993-a55b-620ec0221206.png&w=3840&q=100)

![[무료 웨비나] AI 캐릭터 숏폼 클래스 - 프롬프트부터 완성까지](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fmomo%2Fthumbnail%2F1384b00f-a055-40f0-8005-af8c4003b704.png&w=3840&q=100)

![[무료] Cursor로 웹서비스 만들기 - 바이브 코딩 스터디 설명회](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fmomo%2Fthumbnail%2F020c42f8-10f9-404f-af94-c5d6e3cb448c.png&w=3840&q=100)

![[AI 기업교육 사례] 뷰티 마케팅 및 영업 실무 DX 역량 세미나](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fpost%2Fattachment%2F5335%2F93516e35-3fba-4867-bfdb-e1686eaaa808.png&w=3840&q=75)

![[기업 AX 사례] 파이썬 및 LLM 기반 AX성과와 AX산출물 사례](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fpost%2Fattachment%2F5303%2Fc3252bd4-499d-4bf2-abb9-419e8031f92c.png&w=3840&q=75)

![[기업 AX사례] 우리 조직의 단계는 DX or AX?](/_next/image?url=https%3A%2F%2Fresources-public-prd.modulabs.co.kr%2Fpost%2Fattachment%2F5253%2F969bce1c-1124-4254-b20f-4dcfc2ae44b7.png&w=3840&q=75)