한 줄 소개

고성능·저지연·확장 가능한 AI 추론 운영 플랫폼

분야

NATURAL_SCIENCES, ENGINEERING

목표 결과물

OPEN_SOURCE, PAPER

랩 소개

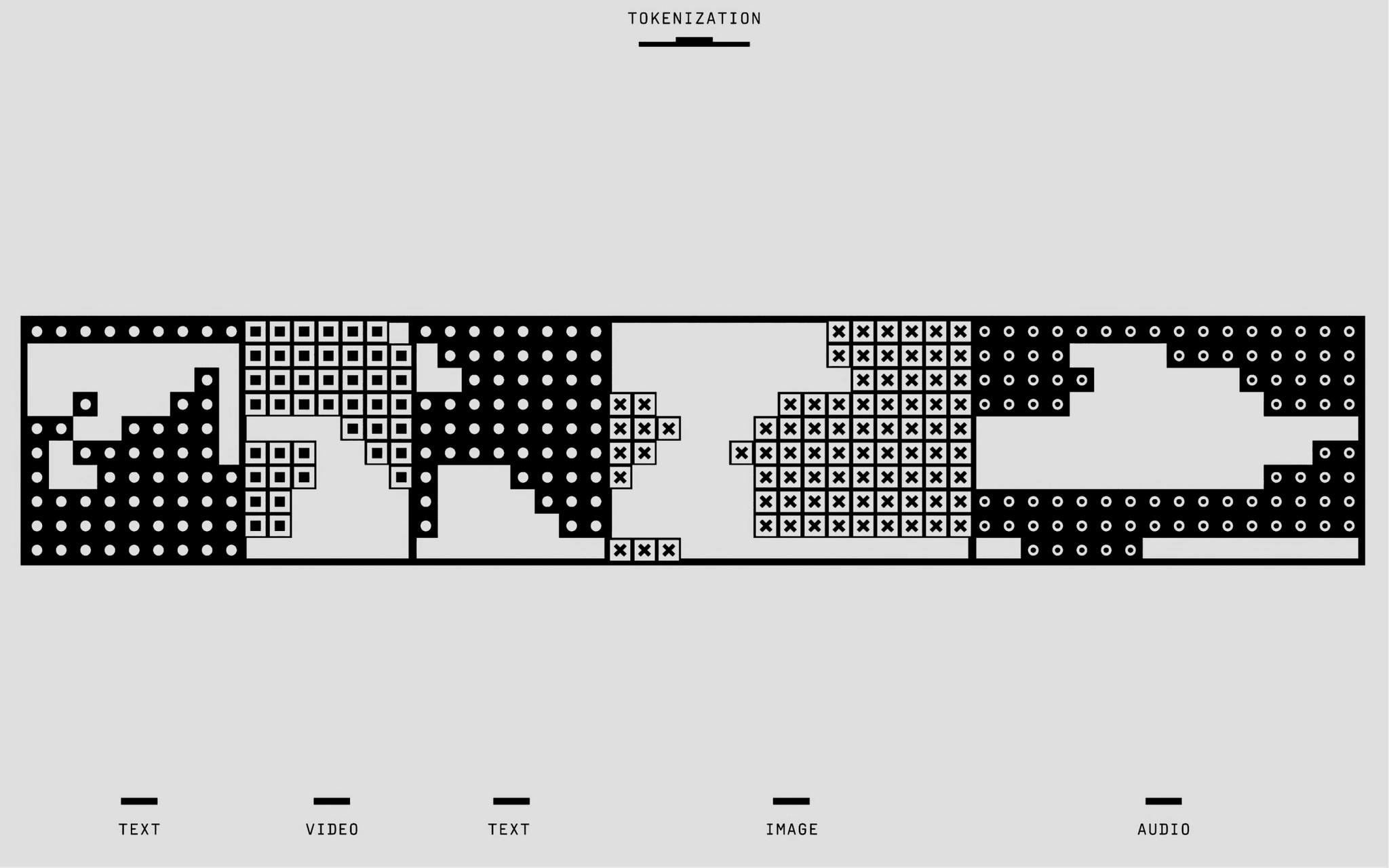

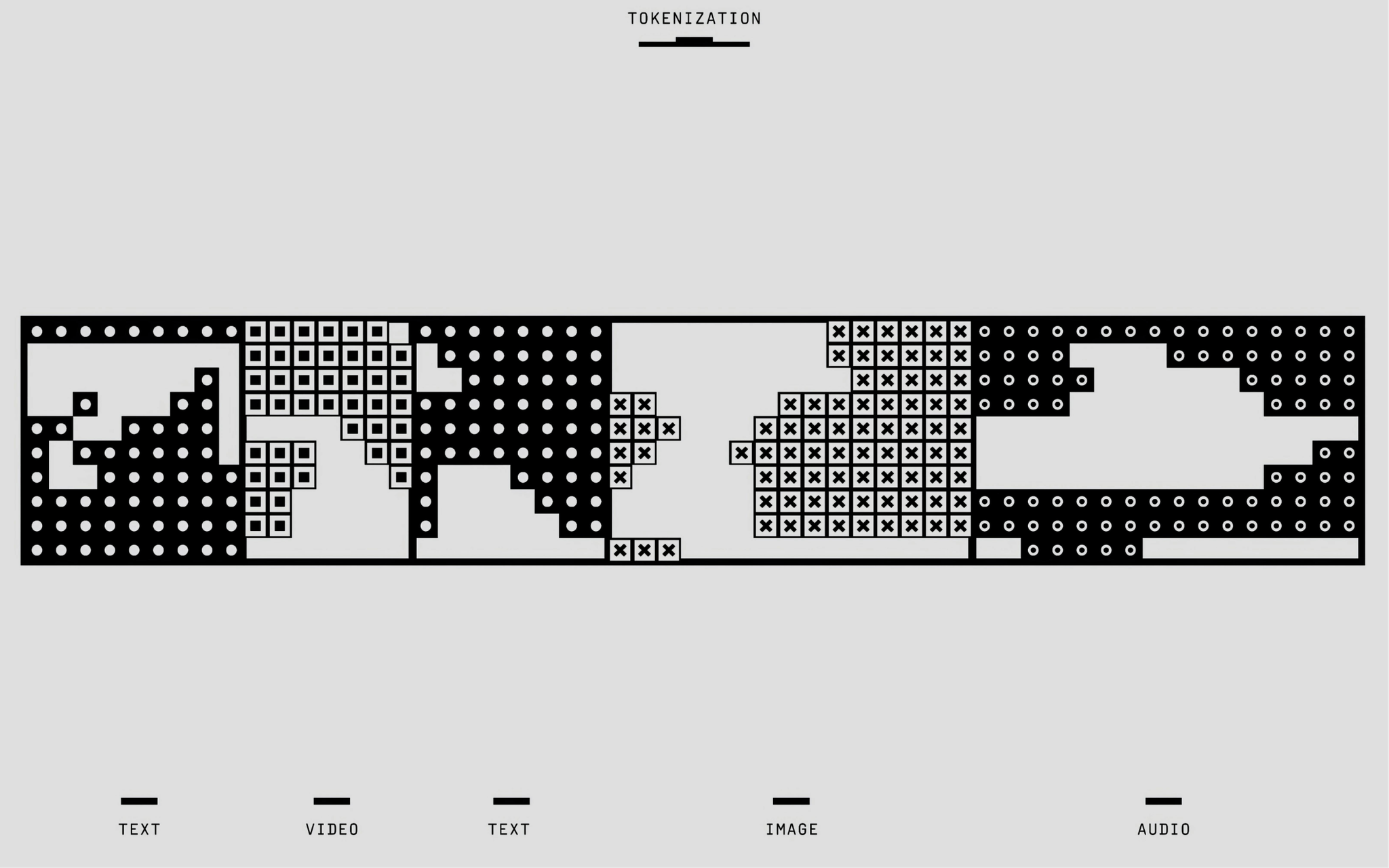

AI Inference Lab은 대규모 언어모델(LLM)·멀티모달 모델 등을 실제 서비스에 올릴 때 필요한 추론(Serving) 효율화에 초점을 둔 연구/실습 커뮤니티입니다. 고처리량 배치 추론, 지연시간 단축, GPU 활용 최적화, 엔지니어링 스택(vLLM, SGLang, Triton, CUDA Graphs 등) 비교·적용 같은 실무 문제를 중심으로 운영됩니다

운영 방식

운영은 정기 세미나와 실습, 논문·레포 리뷰, 벤치마크 재현, 오픈소스 엔진/서빙 프레임워크 비교 테스트, 결과 공유 등의 형태로 진행됩니다. 일부 커뮤니티는 8~12주 단위 트랙을 구성해 논문·문서화·코드 산출물을 목표로 하며, 온라인 위주 진행에 오프라인 모임을 간헐적으로 병행하기도 합니다

커리큘럼

1주차: 목표 정의와 베이스라인 구축

2주차: 배치·스케줄링과 KV 캐시

3주차: 모델 경량화 I (양자화 중심)

4주차: 모델 경량화 II (프루닝/지식증류)

5주차: 런타임·컴파일 최적화

6주차: 멀티 GPU/노드 확장과 메모리 공학

7주차: 운영 신뢰성·관측성

8주차: 종합 프로젝트 발표

참여 요건

필수 요건 기본 역량 Python 사용 경험과 리눅스 셸/Docker 기본 명령에 익숙할 것 PyTorch 또는 주요 딥러닝 프레임워크 중 하나 실습 경험 Git으로 코드 버전 관리와 간단한 PR 리뷰 가능 장비/환경 GPU 접근 가능한 환경 1개 이상(개인/팀/클라우드 중 택1). 최소 사양 예시: LLM 실습 기본: 16–24GB VRAM 단일 GPU 또는 동급 클라우드 인스턴스 양자화·서빙 최적화 심화: 24–48GB VRAM 또는 2개 이상의 GPU 로컬 또는 원격 Linux 환경, Docker 활용 가능 우대 요건 추론/서빙 스택(vLLM, SGLang, TGI, TensorRT-LLM, Triton 등) 실사용 경험 모델 경량화(AWQ/GPTQ/프루닝/증류) 또는 프로파일링(Nsight, PyTorch Profiler) 경험 프로덕션 운영 경험(모니터링, 배포전략, SLA 관리)

사전 질문

이름/소속/직무

연락처(이메일/슬랙 ID)

이번 트랙에서 가장 달성하고 싶은 목표는 무엇인가요?

참가 동기와 성공 기준을 서술해주세요.

실무/프로젝트에서 LLM 또는 모델 서빙 경험

사용 경험이 있는 추론/서빙 스택

심화로 다뤄주길 원하는 주제

랩장 소개

강건

현재 AI 스타트업에서 CSO로 재직 중입니다

AI Inference LAB

모임 기간

2025.09.06 - 2025.11.08

모임 일시

매주 토요일 13:00 ~ 15:00

장 소

모두의연구소 강남캠퍼스

모집 기간

2025.10.20 - 2025.10.21

모집 인원

40명

선발 방식

사전 질문 기반 심사 + 온라인 커피챗